在當今信息爆炸的時代,高效地獲取和處理網絡數據已成為企業和機構的重要需求。網絡爬蟲(Web Crawler)作為一項核心技術,在北京計算機系統服務領域扮演著越來越關鍵的角色。本文將從網絡爬蟲的基本原理入手,探討其在計算機系統服務中的應用與挑戰。

一、網絡爬蟲的定義與工作原理

網絡爬蟲,又稱網絡蜘蛛或網絡機器人,是一種按照預設規則自動抓取互聯網信息的程序或腳本。其核心工作原理可概括為以下幾步:

- 種子URL設定:爬蟲從初始的URL列表(種子URL)開始工作,這些URL通常由用戶指定。

- 頁面抓取:爬蟲通過HTTP/HTTPS協議訪問目標網頁,下載頁面內容(通常是HTML代碼)。

- 數據解析:解析下載的頁面,提取有用信息(如文本、圖片鏈接等),并識別頁面中的其他鏈接。

- 鏈接追蹤:將新發現的鏈接加入待抓取隊列,循環執行抓取和解析過程,直到滿足停止條件(如達到深度限制或抓取數量)。

- 數據存儲:將提取的結構化數據保存到數據庫或文件中,供后續分析使用。

二、網絡爬蟲的關鍵技術要點

- 請求與響應處理:爬蟲需要模擬瀏覽器行為發送請求,并處理服務器的響應(包括狀態碼、重定向等)。

- 解析技術:常用HTML解析庫(如BeautifulSoup、lxml)或正則表達式來提取數據,現代爬蟲也常結合JavaScript渲染工具(如Selenium)處理動態頁面。

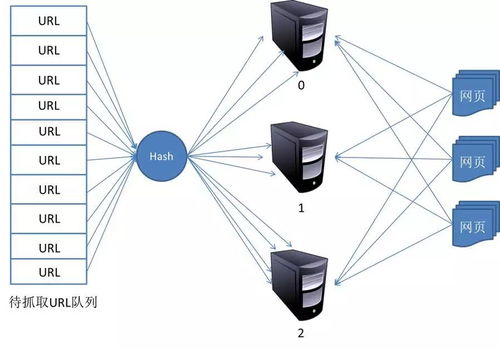

- 去重策略:通過哈希算法或布隆過濾器避免重復抓取相同URL,提高效率。

- 遵守robots協議:尊重網站的robots.txt文件,避免抓取被禁止的頁面,體現合法合規性。

- 反爬蟲應對:針對IP封鎖、驗證碼等反爬機制,需采用代理IP池、請求頭偽裝或延遲請求等技術。

三、網絡爬蟲在北京計算機系統服務中的應用

北京作為科技創新中心,其計算機系統服務行業廣泛利用網絡爬蟲技術支撐業務發展:

- 市場調研與競爭分析:企業通過爬蟲收集行業數據、產品價格和用戶評論,輔助決策制定。

- 輿情監控:政府或機構實時抓取新聞、社交媒體信息,及時感知公眾意見和突發事件。

- 垂直信息聚合:在招聘、房產、電商等領域,服務商整合多平臺數據提供一站式查詢服務。

- 學術與科研:高校及研究機構抓取公開論文、專利數據,支持學術分析與技術創新。

- 安全監測:網絡安全公司利用爬蟲掃描漏洞、追蹤威脅情報,增強系統防護能力。

四、挑戰與合規性考量

在北京開展計算機系統服務時,網絡爬蟲的應用需注意以下問題:

- 法律與倫理邊界:嚴格遵守《網絡安全法》等法規,避免侵犯隱私、知識產權或構成不正當競爭。

- 數據安全:確保抓取的數據存儲與傳輸安全,防止泄露敏感信息。

- 資源消耗控制:合理設置抓取頻率,避免對目標網站服務器造成過大壓力。

- 技術更新適應:隨著網站反爬技術升級,爬蟲系統需持續優化以保持有效性。

五、未來發展趨勢

在北京計算機系統服務的推動下,網絡爬蟲技術正朝著智能化、分布式和合規化方向發展:

- AI融合:結合自然語言處理和機器學習,提升數據提取的準確性和語義理解能力。

- 云化與分布式架構:利用云計算資源實現大規模并發抓取,提高效率和可擴展性。

- API優先策略:越來越多網站提供開放API,鼓勵合法數據交換,減少對爬蟲的依賴。

- 合規自動化工具:開發集成法律規則檢測的爬蟲系統,自動規避合規風險。

網絡爬蟲作為連接海量網絡數據與計算機系統服務的橋梁,其基本原理的深入理解和正確應用,對于北京乃至全國的數字化轉型具有重要意義。服務提供商應在技術創新與合規經營之間找到平衡,以促進健康、可持續的數據生態發展。